Правила выбора — оперативная память. Что скрывается за цифрами из технических характеристик

В «Игромании» №4/2013 мы запустили серию материалов «Правила выбора», посвященную основным техническим параметрам компьютерного железа. Несмотря на общее название, каждая статья полностью самостоятельна и рассказывает не только о том, какими характеристиками обладает определенный тип оборудования, но и о том, на какие из них важно обращать внимание, а на какие не очень.

В первых двух выпусках мы успели разобраться с процессорами и материнскими платами, теперь пришла очередь оперативки. Параметров у нее не то чтобы много, но все они достойны пристального внимания. Сегодня мы выясним, сколько гигабайтов брать, так ли уж важна многоканальность и стоит ли переплачивать за частоту. Ну а для закрепления теории проведем серию экспресс-тестов и расскажем, откуда вообще взялась оперативка и какие еще варианты были в прошлом.

Объем

Определить роль оперативки в компьютере несложно. Нашей главной вычислительной единице, процессору, для беспрерывной работы необходима постоянная подпитка данными. Все дровишки сложены на винчестере, но кристаллу он сродни огромному складу, находящемуся за тысячу километров. Информация с него идет слишком медленно и не может удовлетворить потребности камня. И вот чтобы дорогая штука не простаивала, существует оперативная память, локальный сарайчик, в который заранее завозятся нужные материалы и по мере надобности отправляются к ЦП на запредельной для обычного жесткого диска скорости.

Что же хранится в сарайчике? Да все подряд. Если интересно, нажмите прямо сейчас Ctrl+Alt+Delete и посмотрите на цифры в «Диспетчере задач». Гигабайта полтора занимает десяток открытых в браузере вкладок, около сотни мегабайт кушает антивирус, понемногу заполняет пространство системное ПО. И пока остается свободное место, выглядит это мирно и буднично. Ключевое слово — «пока».

Запуск ресурсоемкого приложения или даже открытие особо «тяжелой» странички в Google Chrome — и памяти как не бывало. С точки зрения бестолковой железки, все нормально. Ну нет быстрого хранилища, и фиг с ним: закинем файлы в «своп» (кусочек HDD, выделяемый на подобные случаи) и будем работать дальше. Для нас же такое решение оборачивается адом: тормоза, зависания и разбитые мышки с клавиатурами.

Бороться с ахтунгом можно тремя способами. Первый — перестать нервно кликать по иконкам и пойти пить чай. Рано или поздно система разберется с творящимся ужасом, перераспределит нагрузку и вернется к нормальному состоянию. Второй — следить за запущенными программами и не допускать переполнения памяти: заранее закрывать ненужные вкладки в браузере, завершать работу с Word, фотографиями и графическими редакторами. Ну и третий — самый простой — наращивать объем оперативки.

Сколько брать?

Сколько понадобится системе — зависит от ваших потребностей. Для офисной работы и активного интернет-серфинга достаточно 4 ГБ. Любителям посмотреть онлайн-видео лучше обзавестись 8 ГБ. Ну а людям творческих профессий, не мыслящих себя без фото/аудио/видеоредакторов, может не хватить и 128 ГБ.

Что же касается игр, то вы будете приятно удивлены. На fps объем практически не сказывается. Мы проверили BioShock Infinite и «тяжелейший» Metro: Last Light на стенде с 2, 4, 8 и 12 ГБ оперативки. Между первым и последним вариантами разница составила всего 3%! Конечно, свою роль тут сыграла «чистота» операционки, но общая тенденция понятна: при ограниченном бюджете деньги разумнее вкладывать в видеокарту, а не «лишние» гигабайты, результат будет ощутимее.

Куда сложнее определиться, какие именно планки ставить. Наиболее распространенные — по 2/4/8 ГБ, хотя бывают и раритеты по 1 ГБ или даже по 512 МБ. Казалось бы, самое простое — взять модель потолще и не забивать голову ерундой. Но многих подобная легкомысленность пугает: «А как же двухканальность?» Да, есть такая штука.

Каналы

Как мы уже успели объяснить, память забирает данные с жесткого диска и передает их процессору. Работать по воздуху она не умеет и пользуется шиной данных, за глаза называемой каналом. За такт он может передать до 64 бит информации, а благодаря некоторым особенностям оперативки и все 128 бит (что и зашифровано в названии — Double Data Rate (DDR)). Цифры эти, надо сказать, более чем внушительные и для DDR3-1066 МГц обеспечивают пропускную способность в 8528 МБ/с (та самая маркировка PC-8500). Проблема одна: канал используется всеми модулями по очереди, а отсюда падение производительности.

Решить задачу взялись с выпуском Pentium 4 — пришпандорили материнке еще одну шину, повесили на нее каждую вторую планку и ввели понятие двухканальности. Последнее означало следующее: если поставить два идентичных модуля в слоты разных каналов, то компьютер их воспримет как одну, особо жирную плашку памяти и будет общаться с ней на скорости 256 бит за такт. То есть увеличит пропускную способность с 8528 до 17 056 МБ/с.

Звучит многообещающе, но только в теории. По нашим тестам в Everest, прибавка от дополнительной дорожки составляет всего 3 ГБ/с, которые в играх выражаются в «плюс 2-3%» к счетчику fps (смотрите наши таблички). Конечно, с учетом сравнимой стоимости 2х2 ГБ и 1х4 ГБ — бонус приятный, жертвовать им не стоит, но есть нюанс.

Материнская плата поддерживает строго определенное количество памяти. В ТТХ записано «4х DDR3 до 16 ГБ»? Значит, чипсет может принять четыре модуля объемом до 4 ГБ каждый. Возьмете версии меньшей емкости — в будущем, при апгрейде, не сможете реализовать весь потенциал своей системы.

Если денег сразу на две рекомендуемые модели не хватает, ничего страшного. Берите одну, потом докупите еще планку и организуете двухканалку. Особых проблем с этим сейчас нет, главное — придерживаться правила одинакового объема и скорости, о которой мы расскажем отдельно.

За скоростью

Стандартом для оперативки сегодня считается 1333 МГц. Однако есть планки гораздо быстрее и заметно дороже. Зачем они нужны? Да все для того же — увеличения пропускной способности.

Рассчитывается она просто: частоту модуля умножаем на ширину шины (64 бит) и делим на восемь для перехода к байтам. Из этой формулы вытекает логичное заключение: скорость напрямую влияет на пропускную способность, а значит, ведет к прибавке fps. Только вот если отталкиваться от тестов двухканальности, то для еще одной пары кадров частоту надо повысить в два раза. То есть купить вместо DDR3-1333 МГц версию на 2600 МГц, которая в полтора раза дороже. Стоит ли оно того — решать вам.

В случае положительного ответа не забудьте проверить, поддерживает ли материнка выбранные модели: доступные варианты отмечаются в той же графе, что и максимальный объем. Ну и обратите внимание на тайминги планок. Записываются они в виде четырех чисел — например, «9-9-9-24». Каждая цифра указывает, сколько тактов нужно модулю для перехода к следующей строчке или столбцу с данными. Чем меньше значения, тем лучше для производительности. Как правило, с поднятием частоты тайминги увеличиваются, а это приводит к росту нежелательных задержек.

Как видите, ничего сложного в выборе планок памяти нет. Определяемся с нужным объемом, решаем, необходима ли лишняя скорость, и вперед, за покупками. С производителями можно особо не напрягаться — чипы всем в основном поставляет либоSamsung*, либоHynix. То же касается и мощного охлаждения. Память не склонна к перегреву, и даже в топовые компьютеры с несколькими видеокартами набирают самые обычные планки по 300 рублей за 1 ГБ.

Таблица 1

Тестовый стенд

Материнская плата

MSI Eclipse SLI

Процессор

Intel Core i7-920

Кулер

Scythe Yasya

Оперативная память

6x Kingston HyperX DDR3-2000 МГц, 2 ГБ

Жесткий диск

Seagate Barracuda 7200.10

Твердотельный накопитель

Kingston SSDNow, 64 ГБ

Блок питания

Hiper K900

Таблица 2.

Синтетические тесты

EVEREST Ultimate Edition 5.5

Чтение (МБ/с)

2х 2 Гб, 1066 МГц

11 028

1х 4 ГБ, 1066 МГц

8229

Запись (МБ/с)

2х 2 Гб, 1066 МГц

9622

1х 4 ГБ, 1066 МГц

8275

Копирование (МБ/с)

2х 2 Гб, 1066 МГц

12 858

1х 4 ГБ, 1066 МГц

10 752

Задержки (нс)

2х 2 Гб, 1066 МГц

61,2

1х 4 ГБ, 1066 МГц

55,5

3DMark 11

Graphics

2х 2 Гб, 1066 МГц

17 017

1х 4 ГБ, 1066 МГц

17 032

1х 2 ГБ, 1066 МГц

16 960

4x 2 ГБ, 1066 МГц

17 395

6х 2 ГБ, 1066 МГц

17 030

Physics

2х 2 Гб, 1066 МГц

5 719

1х 4 ГБ, 1066 МГц

5115

1х 2 ГБ, 1066 МГц

4776

4x 2 ГБ, 1066 МГц

5826

6х 2 ГБ, 1066 МГц

5906

Score

2х 2 Гб, 1066 МГц

11 303

1х 4 ГБ, 1066 МГц

10 665

1х 2 ГБ, 1066 МГц

10 304

4x 2 ГБ, 1066 МГц

11 344

6х 2 ГБ, 1066 МГц

11 406

============================

Таблица 3.

Игровые тесты

BioShock Infinite

2х 2 Гб, 1066 МГц

102,3

1х 4 ГБ, 1066 МГц

99,5

1х 2 ГБ, 1066 МГц

98,8

4x 2 ГБ, 1066 МГц

104,6

6х 2 ГБ, 1066 МГц

104

Metro: Last Light

2х 2 Гб, 1066 МГц

38

1х 4 ГБ, 1066 МГц

36,7

1х 2 ГБ, 1066 МГц

36,3

4x 2 ГБ, 1066 МГц

37,9

6х 2 ГБ, 1066 МГц

37,5

32 или 64 бит

Для того чтобы использовать в компьютере больше 4 ГБ оперативки, необходимо ставить 64-битные версии операционных систем. Как ни странно, требование это не надуманно и легко объясняется.

В электронике вся информация хранится в двоичном коде: записывается последовательностью «единиц» и «нулей». Каждое такое значение занимает в памяти один бит. Собственно, их количество и роль можно представить как число клеточек в тетради, в которые разрешается занести ту или иную цифру. Если позиций всего восемь, то в них можно записать не больше 256 последовательностей (28). То есть количество вариантов чисел и их точность после запятой будут сильно ограничены. Если же выдать 32 клетки, то диапазон расширится до 4,3 млрд последовательностей (232). В случае с 64 клетками он достигнет астрономических 18 446 744 трлн значений! При чем тут память? Сейчас объясним.

Физически один бит оперативки - это набор из транзистора и конденсатора, маленькой батарейки. Если на последней есть заряд, для компьютера это означает «единицу», нет - «нуль». Каждый такой тандем элементов имеет свой собственный адрес, по которому процессор и находит месторасположение информации. Так вот, 32 бит хватает на нумерацию всего лишь 4 ГБ. Для большего числа вариантов нужно использовать 64-битную запись, позволяющую пронумеровать до 16 экзабайт (1024 ГБ).

Отметим, что адресность памяти - это одно из главных преимуществ оперативки, позволяющее напрямую обращаться к нужной ячейке, а не тратить время и считывать данные последовательно. По-научному такая особенность называется «динамической памятью», а сама оперативка именуется «запоминающим устройством с произвольной выборкой, ЗУПВ» (Dynamic Random Access Memory, DRAM). А вот за популярное в народе «оперативное запоминающее устройство, ОЗУ» в профильных институтах не только голову, но и кое-что похуже отрывают.

Вспомнить все

История оперативной памяти

Пока некоторые обсуждают будущий приход DDR4 и связанные с этим приросты к показателям скорости/таймингов/энергопотребления, мы решили обернуться и посмотреть, а как же все это вообще начиналось и откуда взялась столь близкая сердцу оперативка. Обычно в подобных материалах принято вспоминать лишь многочисленные типы современной DRAM, но мы заберемся куда дальше. Ведь первые образцы этих устройств выглядели гораздо интереснее и работали на совершенно иных принципах.

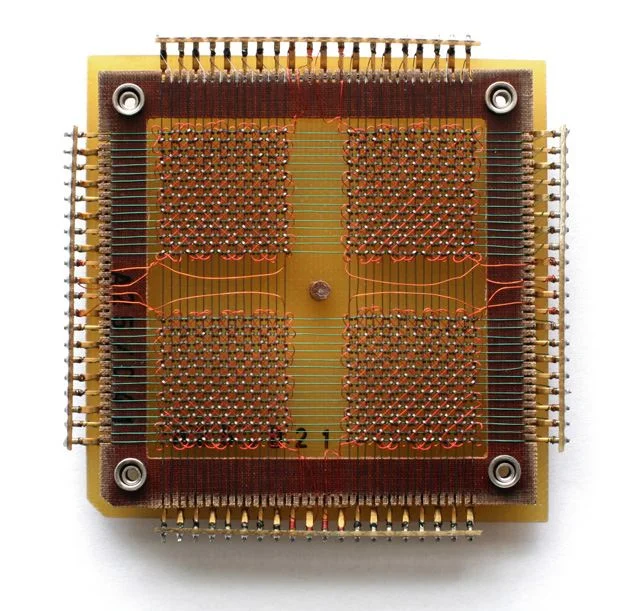

Первая DRAM и по совместительству прямой предок стоящей в вашем компьютере DDR3.

До нашей эры

О необходимости быстрого хранилища высказывался аж сам Чарльз Бэббидж, когда в 1834 году, создав первую в мире счетную машину, засел за разработку аналитического аппарата размером с дом. К сожалению, тогдашняя элита его светлыми идеями хоть и заразилась, но выдать нужную сумму денег отказалась. Стройка заглохла, страсти как-то сами собой улеглись, да и, если честно, не до оперативки тогда было.

Вспомнили о заветах Бэббиджа только после Второй мировой войны. В 1946 году известный математик и по совместительству один из разработчиков атомной бомбы «Толстяк», Джон фон Нейман, дал описание основных принципов компьютерной архитектуры. Среди них фигурировала и оперативная память в ее нынешнем понимании.

Однако наклепать в то время много-много планок по несколько гигабайт не получалось. Во-первых, до создания транзистора оставался еще год, во-вторых, и сотни байт тогда казались чудом. Поэтому использовать приходилось либо ущербные ртутные линии задержки, которые читались последовательно, то есть, в перекладке на сегодняшний день, чтобы добраться до четвертого гигабайта, нужно было считать предыдущие три. Либо пускать в ход прототипы современной динамической памяти под названием электронно-лучевые трубки имени Фредерика Уильямса.

Ртутные линии задержки хоть и выглядели эффектно, работали из рук вон плохо: информация с них читалась последовательно, и это плохо сказывалось на общей производительности.

Первый шаг

Появились они в 1946 году и подозрительно напоминали экраны военных радаров (их-то Фредерик и разрабатывал в основное рабочее время). Электронный луч в определенном порядке располагал на дисплее зеленые точки, которые затем считывались специальной пластиной с электродами. Зажженный огонек означал «нуль», погасший — «единицу». Главная особенность метода состояла в том, что светящиеся пятнышки можно было снимать в любой последовательности, и за это память получила приписку «с произвольной выборкой» (Random Access Memory, или просто RAM). Отсюда же растут ноги и у определения «энергозависимый носитель». Точки на экране держались всего 0,2 секунды, и их приходилось постоянно обновлять. При отключении питания вся информация стиралась, прямо как в современном ПК.

Использовались трубки Уильямса недолго, примерно с конца 1940-х до первой половины 1950-х годов. Однако наследить в истории все же успели. Самыми известными системами на их основе стали британские Ferranti Mark 1 и Manchester Mark 1, американские IBM 701 и IBM 702 и даже наши, советские, ЭВМ М-1 и «Стрела».

В недостатках изобретения числились малый объем (какие-то 256 байт), сильный нагрев, низкая надежность, общая дороговизна и сравнительно большие размеры. В общем, пришлось ученым опять поднапрячься и придумать память на магнитных сердечниках (Magnetic Core Memory).

Трубка Уильямса, по сути, обычный радарный монитор, на котором зажигались зеленые точки, соответствующие «нулям».

Не поделили

Главной составляющей идеи стало ферритовое кольцо. Если через него провести два провода и подать на них ток, то направление намагниченности объекта изменится, и, соответственно, будет задано одно из двух положений, «единица» или «нуль». Чтобы считать полученный вектор, необходимо добавить еще кабель, на котором при определенных условиях будет появляться импульс.

Как это часто случается, точно сказать, кто первым придумал схему, не выйдет. По одним данным, сначала на эту тему высказался в 1945 году создатель компьютера ENIAC Джон Преспер Экерт. А ее реализацией в 1949-м занялись молодые гарвардские ученые Ван Ань и Вайдун Ву.

По другим сведениям, слава принадлежит Джею Форрестеру из Массачусетского технологического института. Этот видный деятель с 1947 года по заказу Минобороны проектировал суперкомпьютер Whirlwind («Вихрь»). А так как военпром не терпит таких вещей, как «ненадежность», Джей к 1949 году додумался вместо лучевой трубки Уильямса использовать ферритовые кольца. По его словам, ни про каких товарищей из Гарварда он слыхом не слыхивал, а до всего дошел сам.

Кто в этой истории был прав, сейчас уже не разберешь; главное, что к середине 1950-х память на магнитных сердечниках стала использоваться повсеместно. Работала она гораздо быстрее своего предшественника (на скорости около 1 МГц) и могла хранить до 1024 бит данных на сравнительно компактных пластинах размером с ладонь взрослого человека.

Плюс MCM не боялась ни отсутствия электричества, ни повышенной температуры, ни радиации, ни электромагнитных импульсов, а значит, была любимицей военных. Последние ее даже в космос на шаттлах засылали, и не в качестве бесполезной нагрузки, а как рабочий элемент управляющих систем. К примеру, именно с него в 1986 году считывали информацию после взрыва печально известного «Челленджера».

Но, как говорится, ничто не вечно под луной. Через 20 лет безоблачного существования на смену магнитам пришел транзистор, а ферритовые кольца сейчас можно встретить разве что на проводах USB (те самые цилиндры, предохраняющие от паразитных наводок), ну или в «Магазине на диване», где ими лечат все подряд, от геморроя до насморка.

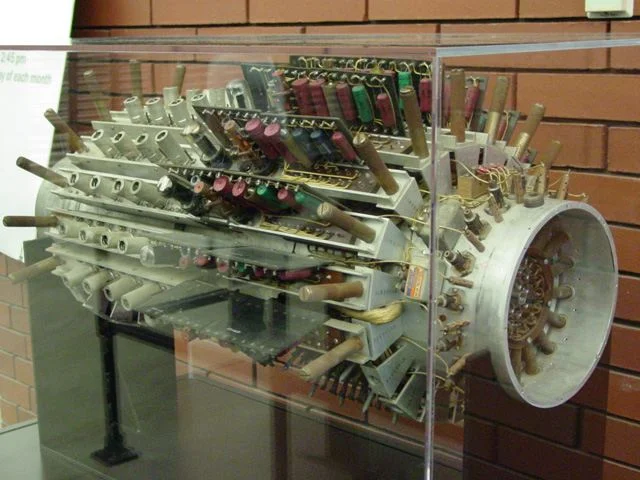

Память на магнитных сердечниках. Каждое пересечение — это ферритовое кольцо, хранящее один бит информации.

Транзистор

Патент на однотранзисторную ячейку памяти DRAM был выдан в 1968 году сотруднику IBM Роберту Деннарду. Он догадался подселить к управляющему элементу конденсатор и зашифровать в нем один бит информации. По словам изобретателя, идея пришла случайно. По дороге домой что-то щелкнуло — вернулся к себе в кабинет и накидал принципиальную схему. Дальше — дело техники и длительных экспериментов. Короче, никаких пришельцев.

Практического применения новой технологии ждали недолго. Уже в 1970-м некая Intel выпустила чип i1103 , первую в мире современную DRAM объемом в 1024 бита. И хотя по сравнению с магнитными модулями она не очень любила экстремальные условия и была энергозависима, именно ее принципы работы легли в основу планок DDR и поставили точку в развитии памяти. Дальше были только усовершенствования.

За 40 лет

В 1980-х оперативка переползла с материнских плат на отдельные планки и перешла c DIP- на современные SIMM-разъемы, которые активно продвигал уже знакомый нам Ван Ань. В 1993 году Samsung выпустила первые образцы Synchronous DRAM и значительно ускорила работу памяти, заставив ее напрямую синхронизироваться с шиной данных и загружать новые команды, не дожидаясь окончания предыдущих. Затем случился переход с SIMM на DIMM-разъемы, позволившие размещать чипы памяти на обеих сторонах модуля. Ну и последнее важное событие — появление текущих Double Data Rate SDRAM в 2000 году, увеличивших пропускную способность в два раза. Дальше мы видели только наращивание частот, емкости и снижение энергопотребления, которые продолжатся и в ближайшем будущем.